Automatisierbarkeit

Automatisierbarkeit der Informationsbereitstellung

Die Qualitätskriterien der EVALITECH-Indikatorik sind durch den Projektpartner Ubermetrics detailliert analysiert, evaluiert und hinsichtlich der Möglichkeit zur Automatisierbarkeit geprüft worden. Für eine beispielhafte Auswahl von Kriterien wurde im Konsortium ein Konzept entwickelt, wie Technologien von Ubermetrics im Rahmen des Information Retrievals angepasst und weiterentwickelt werden können, um erste Rohdaten-Ergebnisse von mehreren Personen mit Acatech- und I4.0-Bezug zur Verfügung gestellt werden können.

Die Umsetzung wurde vom Projektpartner in den folgenden Bausteinen vorgenommen:

Baustein 1: API-Service für ad-hoc Metadaten-Sammlung je Kandidat*in

Der erste Baustein liefert die Datengrundlage für alle Kandidat*innen. Pro Qualitätskriterium wurden mögliche Quellen von Informationen identifiziert, dokumentiert und bezüglich der automatisierten Informationsextraktion evaluiert. Ziel war es, die Automatisierung so weit zu konkretisieren, dass das Risiko weiterer Entwicklungsschritte minimiert wird.

So konnte prototypisch je eine Datenquelle für die folgenden Kriterien angebunden werden:

- H-Index

- Anzahl Zitate der Top-Publikation

- Mitgliedschaft in Forschungsverbünden

- Anzahl betreuter Doktorand*innen

- Wissenschafts- und Innovationspreise

- Github Bewertungen

- Aufrufstatistik Wikipedia

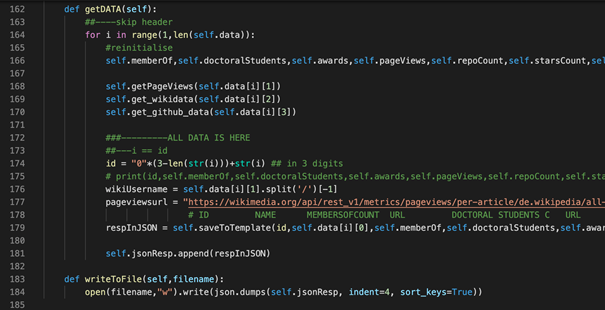

Das Ergebnis ist ein implementierter Algorithmus, der den Namen der Kandidatin oder des Kandidaten und weitere Metainformationen zur Disambiguierung als Input nimmt, die Datenquellen anfragt und die resultierenden Metadaten in ein strukturiertes JSON-Format überführt, das wiederum die Datengrundlage des Demonstrators speist. Dieser Algorithmus und das JSON-Output-Format sind modular so aufgebaut, dass sie beliebig um Datenquellen und Kriterien erweitert werden können.

Baustein 2: API-Service für kontinuierliches Kandidat*innen-Tracking

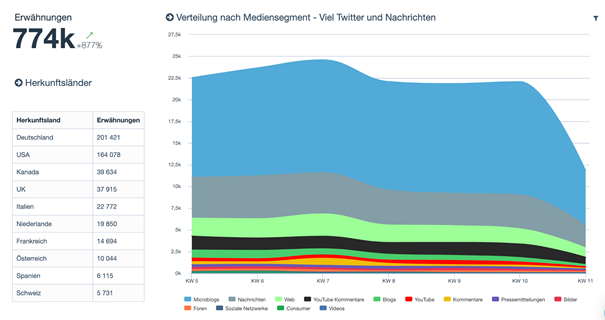

Der zweite Baustein dient der kontinuierlichen Beobachtung der Kandidat*innen. Mithilfe des Namen der Kandidatin oder des Kandidaten und den Daten aus Baustein 1 werden neue Publikationen, Aktivitäten und Sichtbarkeit analysiert und als deskriptive Statistiken in der Plattform Ubermetrics Delta dargestellt. Diese sind ebenfalls über eine API-Schnittstelle verfügbar.

In dem Projekt EVALITECH wurden beispielhaft 650 Wissenschaftler*innen über 6 Monate getrackt und ca. 500k Dokumente erhoben.

Baustein 3: API-Service Identifikation von relevanten Wissenschaftler*innen für ‘unbekannte’ Themenfelder

Der dritte Baustein nutzt ein allgemeines Web Mining, um relevante Wissenschaftler*innen zu identifizieren, die dann wiederum in Bausteine 1 und 2 aufgenommen werden können. Dieser Service basiert auf Informationen aus relevanten Themenfeldern, die mittels Keywords aus dem Themenumfeld definiert werden und nutzt Technologien aus der automatisierten Textverarbeitung, wie Named Entity Recognition (NER), Named Entity Linking (NEL) bzw. der Relation Extraction. Das Ergebnis dieser Verfahren liefert Wissenschaftler*innen, die im Kontext des Themenfeldes häufig erwähnt werden.

In diesem Projekt wurde für das breite Themenfeld “Industrie 4.0” eine Datenmenge von ca. 13k Dokumenten pro Tag generiert und analysiert.

Baustein 4: API-Service zur rekursiven Verfolgung von Verbindungen zu anderen Wissenschaftler*innen

Der vierte Baustein berücksichtigt, dass junge aufstrebende Wissenschaftler*innen in klassischen Metriken aufgrund ihrer kürzeren Lebensläufe weniger zur Geltung kommen als ältere Kolleg*innen. Durch systematische rekursive Berücksichtigung von Co-Autorenschaften, Promovierenden oder Partner*innen bei Firmengründungen soll EVALITECH talentierte und geeignete Kandidat*innen frühzeitig erkennen. Außerdem kann so der Impact von Wissenschaftler*innen auf Fachgebiete durch Messung des Erfolgs der verbundenen Personen weiter verfeinert und validiert werden.

Es werden die Informationen aus den vorherigen Bausteinen aufgegriffen und ähnlich dem Baustein 3 mit Methoden der NLP die Namen und Metadaten extrahiert. Diese durchlaufen dann wiederum als eigenständige Kandidat*innen die Bausteine 1 und 2 und Metadaten und liefern Scores zu neuen potentiellen Kandidat*innen.

Baustein 5: API-Endpunkt um (nicht-öffentliche) Daten durch die Nutzer*innen ergänzen zu lassen

Der fünfte Baustein erlaubt es, Daten zu berücksichtigen, die nicht öffentlich zugänglich sind. Hier können weitere relevante Daten für Kandidat*innen eingetragen werden als Training-Basis für Human-in-the-Loop-Machine-Learning. Die Automatisierung wird hier im Wesentlichen von der Leistung der Relationsextraktion abhängen.